不给对手留活路!英伟达推出“世界上最强大的GPU”——H200

周一(11月13日),英伟达推出新一代人工智能芯片H200,并将其描述为“世界上最强大的GPU”。H200将拥有更大的内存和更快的速度。

周一(11月13日),英伟达推出新一代人工智能芯片H200,并将其描述为“世界上最强大的GPU”。

据官网介绍,H200基于英伟达Hopper架构,是首款搭载HBM3e的GPU。借助HBM3e,H200以每秒4.8TB的速度提供141GB内存,与A100相比,容量几乎翻了一番,带宽增加了2.4倍。与H100相比,H200容量是H100的两倍,内存带宽增加了1.4倍。据悉,H200预计将于2024年第二季度开始发货。

英伟达表示,H200更大更快的内存推动了生成人工智能和大型语言模型(LLM)的加速,同时以更好的能效和更低的总拥有成本(TCO)推进高性能计算(HPC)工作负载的科学计算。

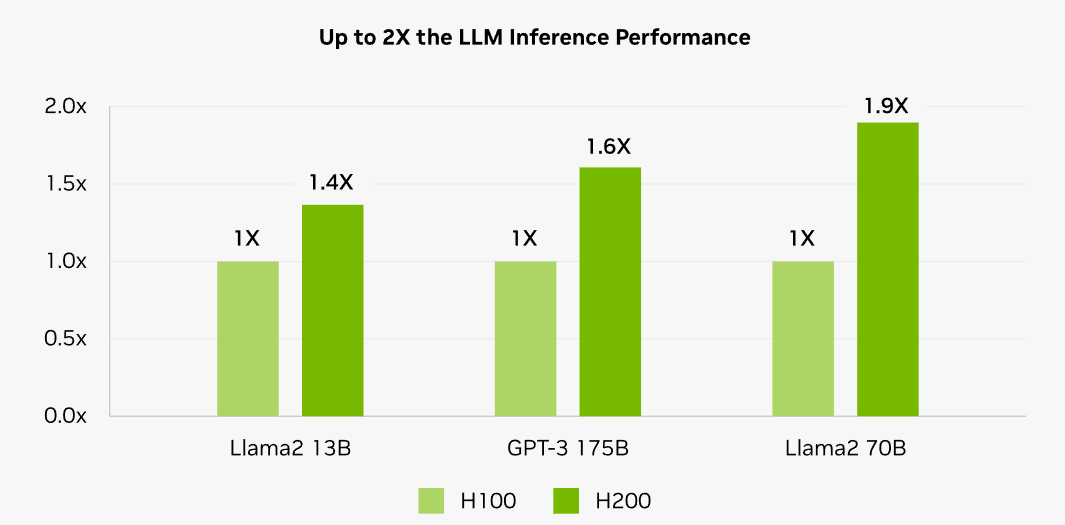

在使用H200之后,与H100相比,Meta的Llama 2(70亿参数)的推理速度几乎翻了一番,OpenAI的GPT-3则提高了1.6倍。英伟达预计,随着未来的软件更新,预计H200的性能将进一步领先并得到改进。

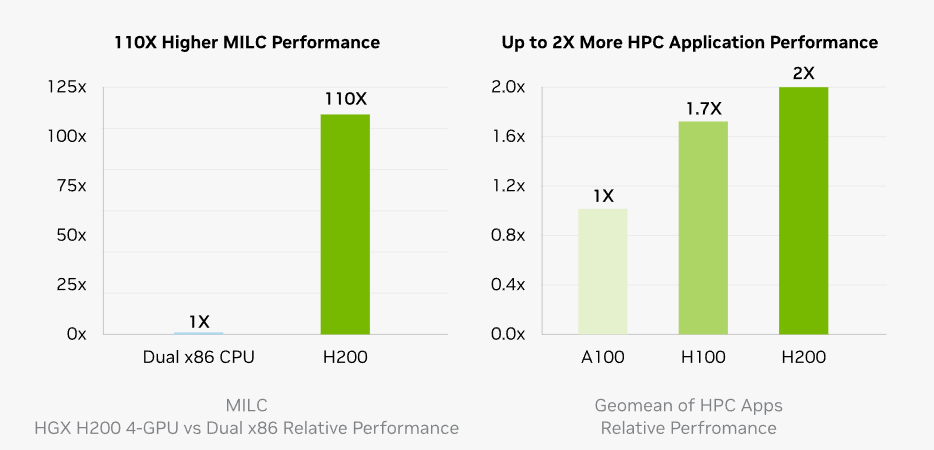

对HPC应用程序来说,内存带宽至关重要,因为它可以实现更快的数据传输,减少复杂的处理瓶颈。对于模拟、科学研究和人工智能等内存密集型HPC应用,H200更高的内存带宽确保了数据的有效访问和操作,与普通CPU相比,得出结果的速度快了110倍。

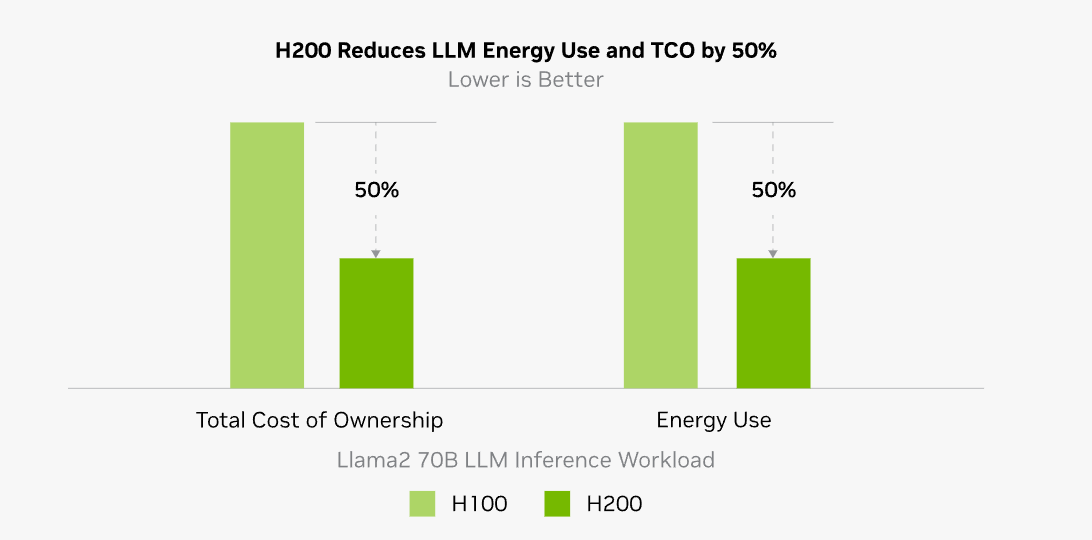

不仅如此,与H100相比,H200能将LLM的总拥有成本和能耗各自降低50%。

英伟达还表示,H200将提供英伟达HGX H200服务器板,相关配置可以与HGX H100系统的硬件和软件都兼容。在这种情况下,英伟达多家合作伙伴如华硕、戴尔、惠普、联想、纬创等可以使用H200更新其现有系统。

英伟达负责超大规模云服务商(Hyperscaler)和HPC的副总裁Ian Buck表示:“要训练生成式人工智能和HPC应用程序,必须使用高速且大内存的GPU来处理大量数据。”。他还补充道:“有了H200,业界领先的人工智能超级计算平台更快地解决了世界上一些最重要的挑战。”

此外,英伟达透露,从明年开始,亚马逊网络服务、谷歌云、微软Azure和甲骨文云基础设施将成为首批部署H200的云服务提供商。

英伟达这一出手,对其竞争对手来说,更是压力满满。AMD旗下正在研制的最新芯片MI300将于年底正式上市。AMD此前表示,MI300与前代产品相比具有更多的内存,使其能够在硬件上安装大型模型来运行推理。

受新一代芯片推出提振,周一英伟达于美股盘中最高涨至490.96美元,接近今年8月31日创下的历史高点493.55美元。

此外,英伟达将于11月21日公布其第三季度收益。市场预计其第三季度营收将达到约160亿美元,同比增长170%。

在多重利好加持下,该股已连续九个交易日上涨,且“九连阳”让该公司股价上涨了近20%。年初至今,英伟达股价上涨超过230%,成为标普500指数中表现最好的股票之一。

对于H100会不会因此“淘汰”的问题,英伟达发言人Kristin Uchiyama表示,H200的推出不会影响H100的生产。“你会看到我们全年的总体供应量有所增加,并且我们将继续长期供应。”

8月份有媒体报道称,英伟达计划在2024年将H100的产量增加三倍。目标是明年将产量从2023年的约50万增加到200万。自去年10月OpenAI爆火以来,人工智能热度只增不减,市场对芯片的需求一直很旺盛,故英伟达想要达成目标并不算难。

除英伟达外,AI热潮让多家芯片制造商都野心勃勃,希望能在这一片新的“蓝海”占据更多的市场份额。

Wolfe Research的Chris Caso在给客户的一份报告中写道,英伟达通常不会更新其数据中心处理器,H200的发布进一步证明了英伟达为应对人工智能市场增长和性能要求而加快了产品节奏,这将进一步巩固其竞争“护城河”。

今年10月份,英伟达告诉投资者,由于旗下的GPU需求旺盛,公司的发布节奏将加快。该公司可能会在明年发布基于即将推出的Blackwell架构的B100芯片。

英伟达并未透露H200的成本及售价。Caso认为,考虑到新版本的性能提升,该公司可能会提高价格。

根据Raymond James的估计,H100芯片的成本在25,000美元至40,000美元之间,而在大模型训练中,通常需要投入数千个芯片才能达到较好的效果。

·原创文章

免责声明:本文观点来自原作者,不代表Hawk Insight的观点和立场。文章内容仅供参考、交流、学习,不构成投资建议。如涉及版权问题,请联系我们删除。